GRU小结

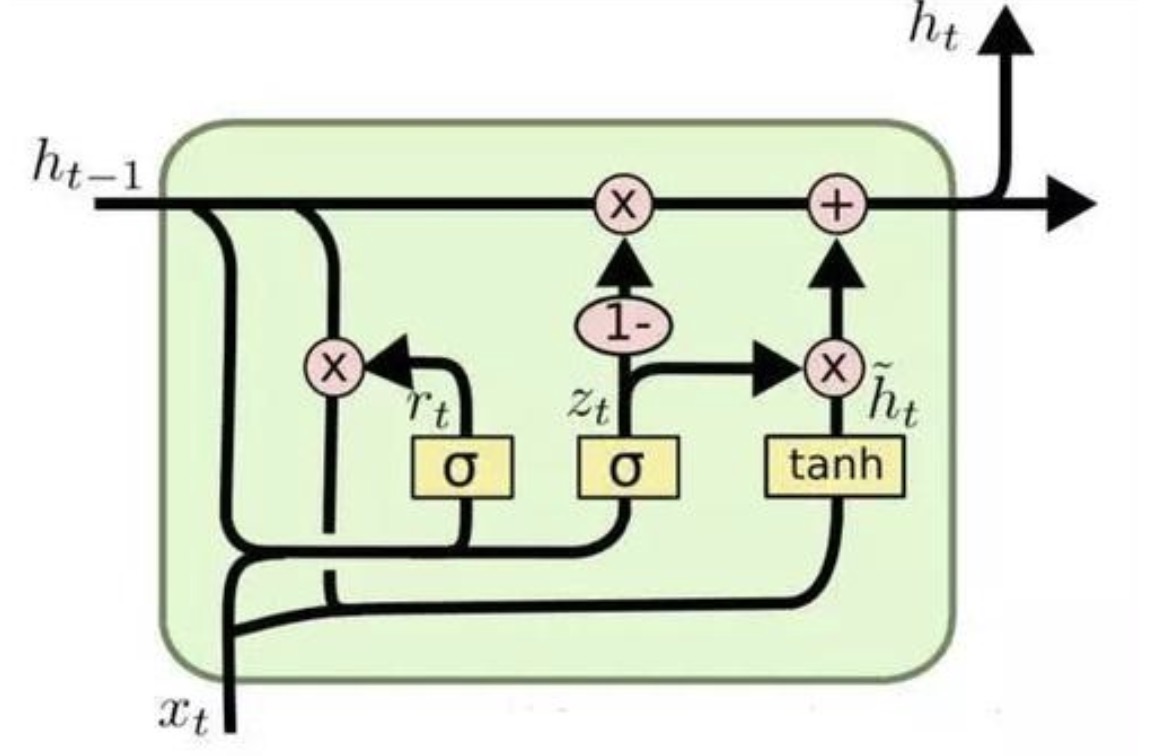

GRU(Gated Recurrent Unit)即门控循环单元,是LSTM的变体. GRU保留了LSTM对梯度消失问题的抗力,但内部更简单. LSTM有:输入门,遗忘门,输出门,GRU单元只有更新门z与重置门r.

其中$z_t$表示更新门,$r_t$表示重置门. 更新门用于控制前一时刻的状态信息被带入到当前状态中的程度,更新门的值越大说明前一时刻的状态信息带入越多。重置门控制前一状态有多少信息被写入到当前的候选集$h^-_t$上,重置门越小,前一状态的信息被写入的越少。

计算公式:

$$r_t= sigmoid(W_r . [h(t-1),x_t])$$ $$z_t= sigmoid(W_z . [h(t-1),x_t])$$ $$h^-_t = tanh(W_h^- .[r_t * h(t-1), x_T])$$ $$h_t = (1-z_t) * h(t-1) + z_t * h^-_t$$