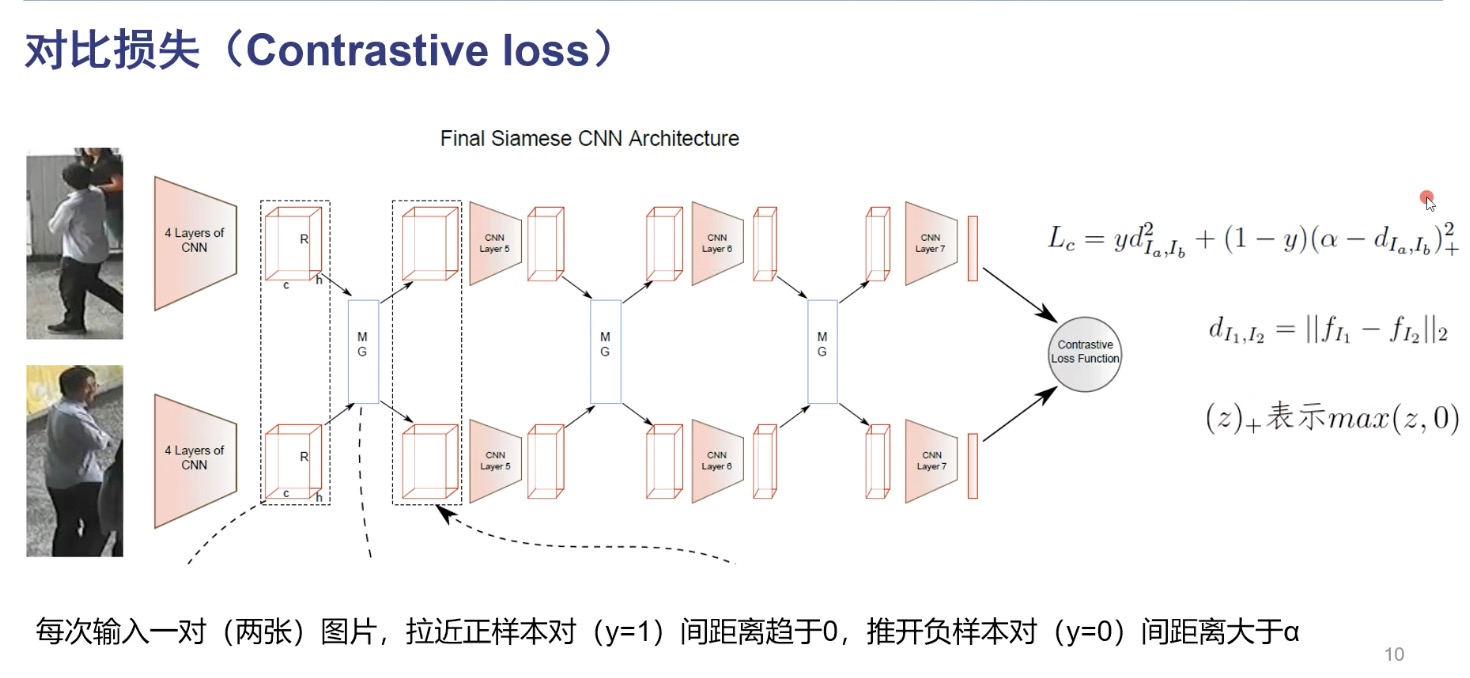

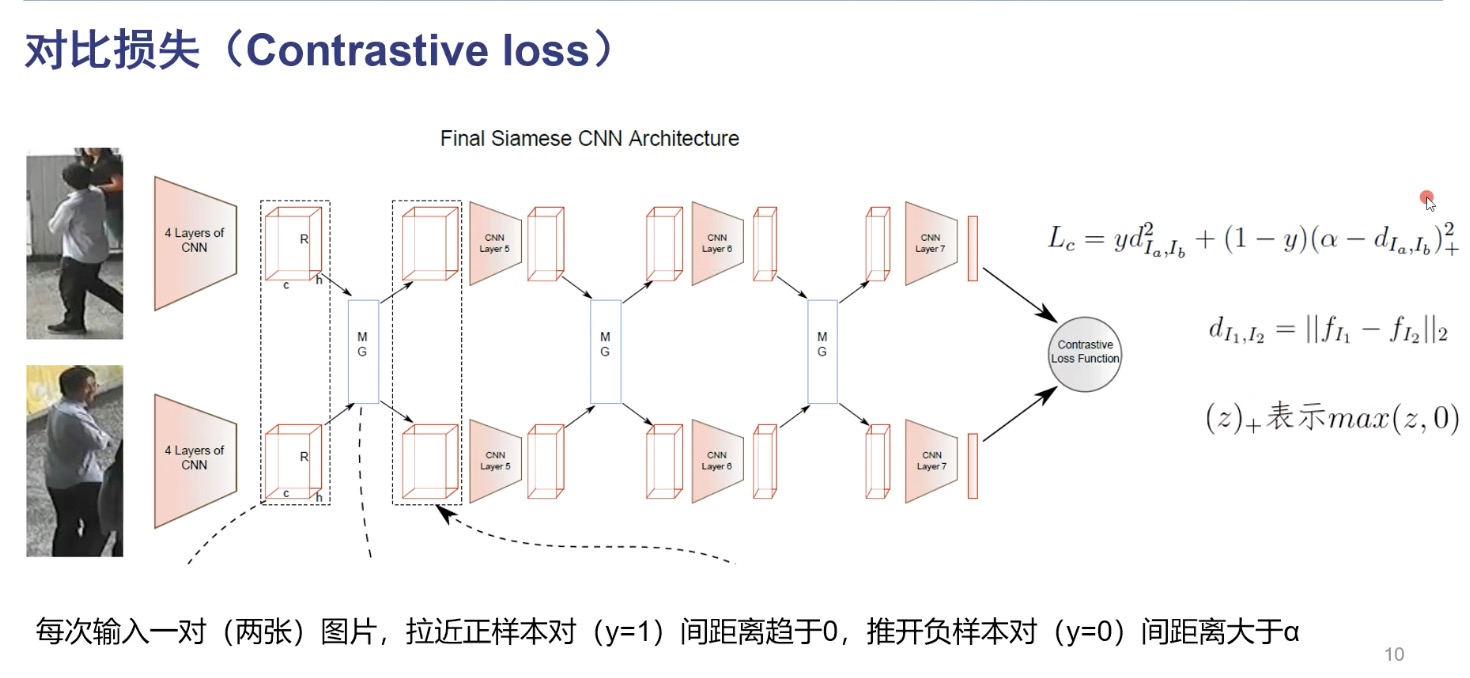

度量学习旨在学习两张图片的相似性,那么久需要设计合适的损失函数能让网络提取到更具有判别能力的特征. contrasitive loss 网络优化目标是最小化损失函数 $L _c$, 输入正

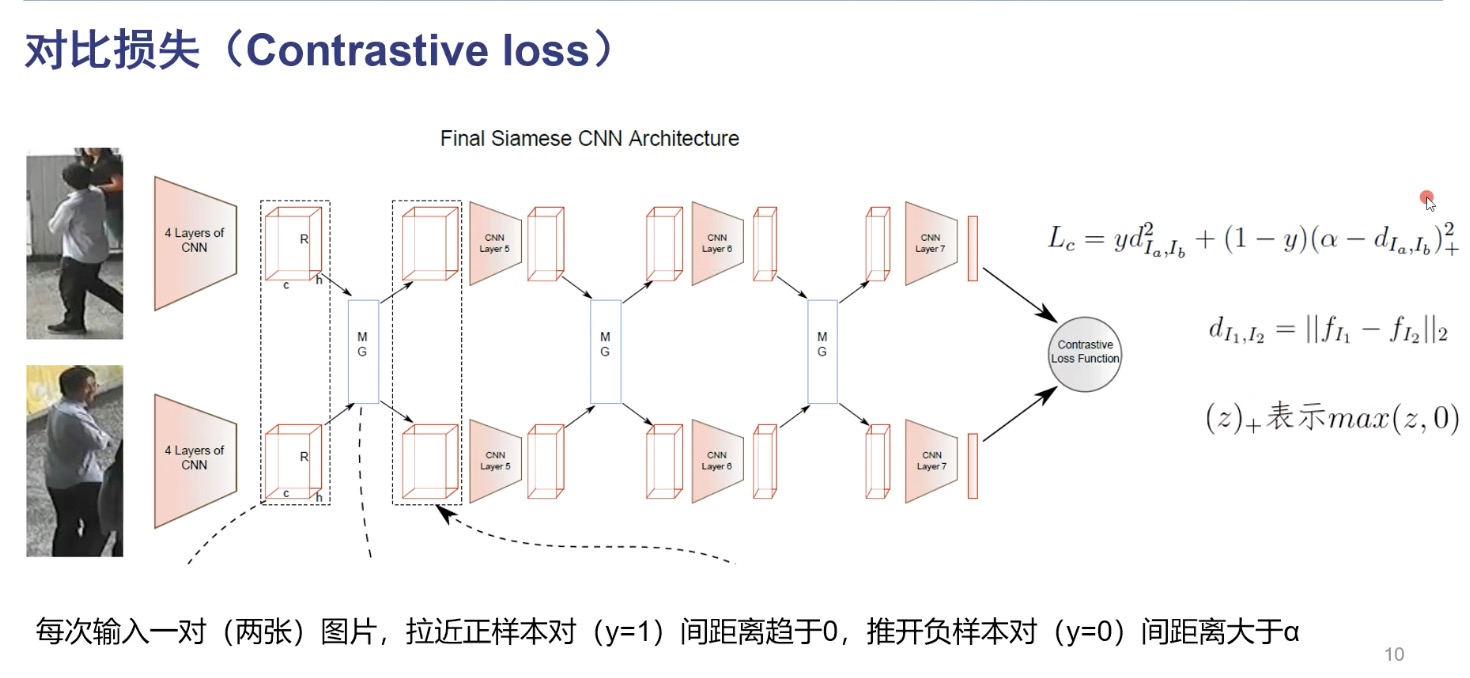

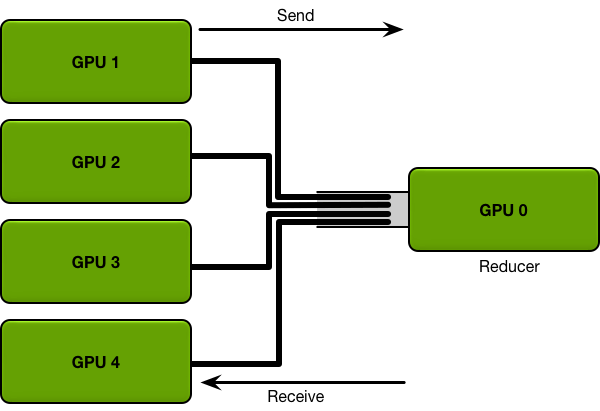

对于算法工程师而言,单卡跑不起来或者跑起来慢是很常见的问题,分布式训练各个框架都有支持。有时候训练模型一张卡放得下但误以为多卡一定就快,训练

在画风迁移与超分辨率重建以及图像修复等视觉领域, 内容损失又称感知损失, 使用的较多, 在此做个记录, 同时也记录下风格损失 内容损失与提取计算 内容损

深度学习中的常见归一化方法主要有: batch Normalization, layer Normalization, instance Normalization, group Normalization. 神经网络学习过程的本质就是为了学习数据分布, 如果没有做归一化处理, 那么每一批次训练数据的分

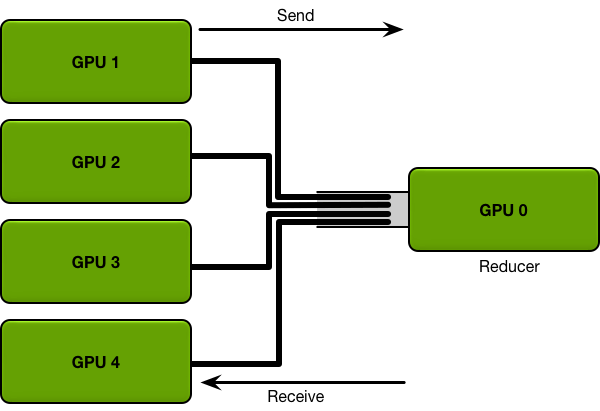

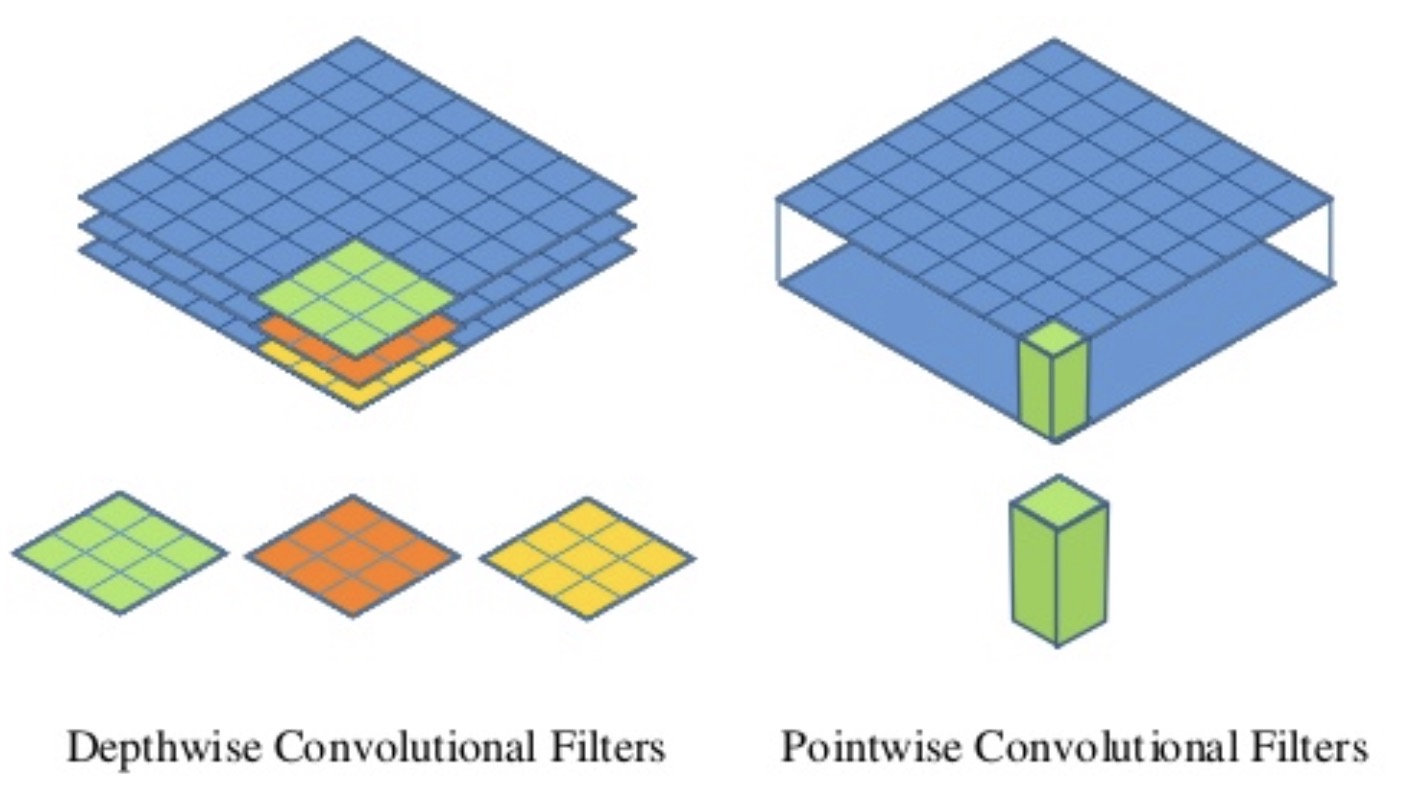

可分离卷积主要包括空间可分离卷积(Spatial Separable Convolutions)、深度可分离卷积(Depthwise Separable Convolutions.

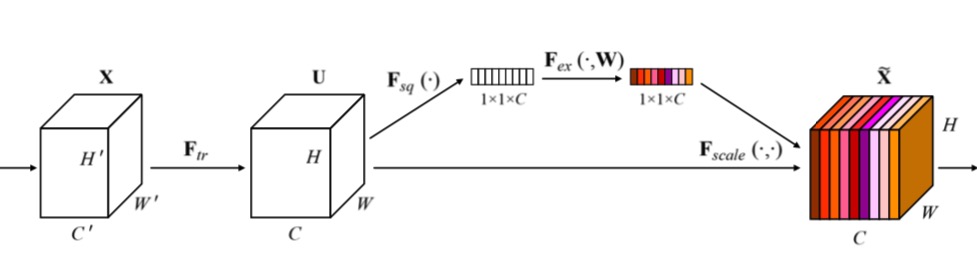

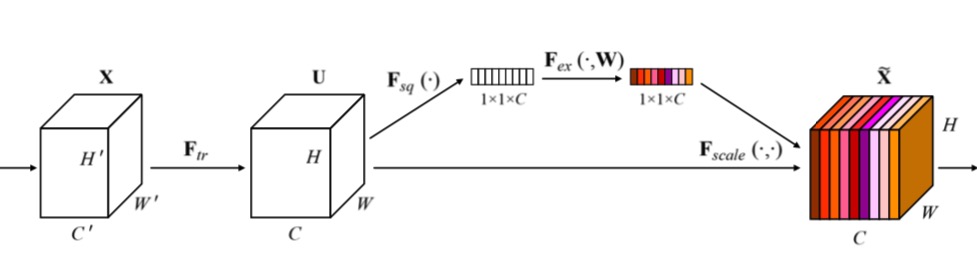

Squeeze-and-Excitation Networks(SENet)是CVPR2018公布的一种全新的图像识别结构,它通过对特征通道间的相关性进行建模,把重要的特征进行强化来提

DCGAN 在 Ian Goodfellow 提出GAN 以来, 在图像领域GAN 可谓被玩的声名大噪. DCAGN 主要是针对卷积实现GAN时, 提出一系列架构设计规则, 使其训练更稳定. 主要有以下

Dlib由C++编写,提供了和机器学习、数值计算、图模型算法、图像处理等领域相关的一系列功能, 对Python 也提供了便利的接口, 但C++ 版功

目标检测主要有两种实现,一是faster-rcnn为代表的proposal two-stage 系列,二是以YOLO为代表的one-stage 的回归网络. 主要区

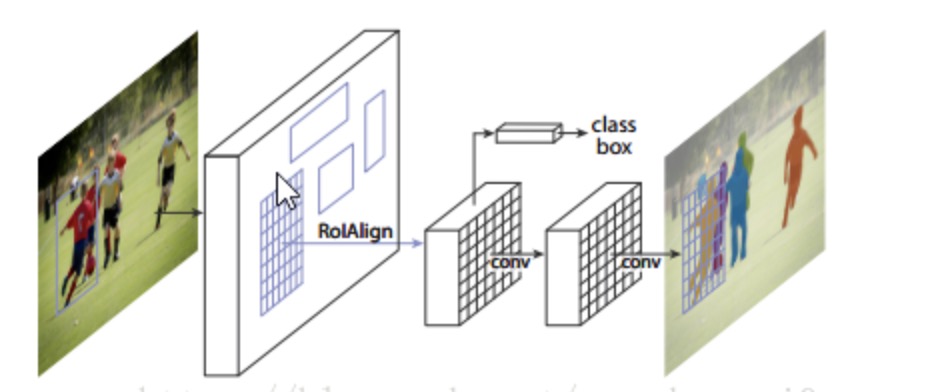

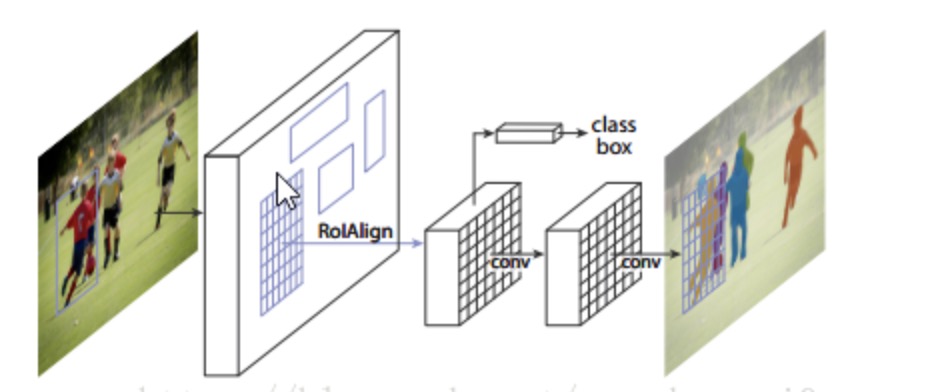

coursera deeplearning.ai目标检测课后实践,构建一个简化版单目标yolo目标检测并添加前景对象分割分支 网络结构 MASK-Rcnn主要是